一、本地安装Deepseek R1

Ollama本地安装Deepseek R1模型

打开 Ollama官网地址,然后点击下载,之后安装到本地。

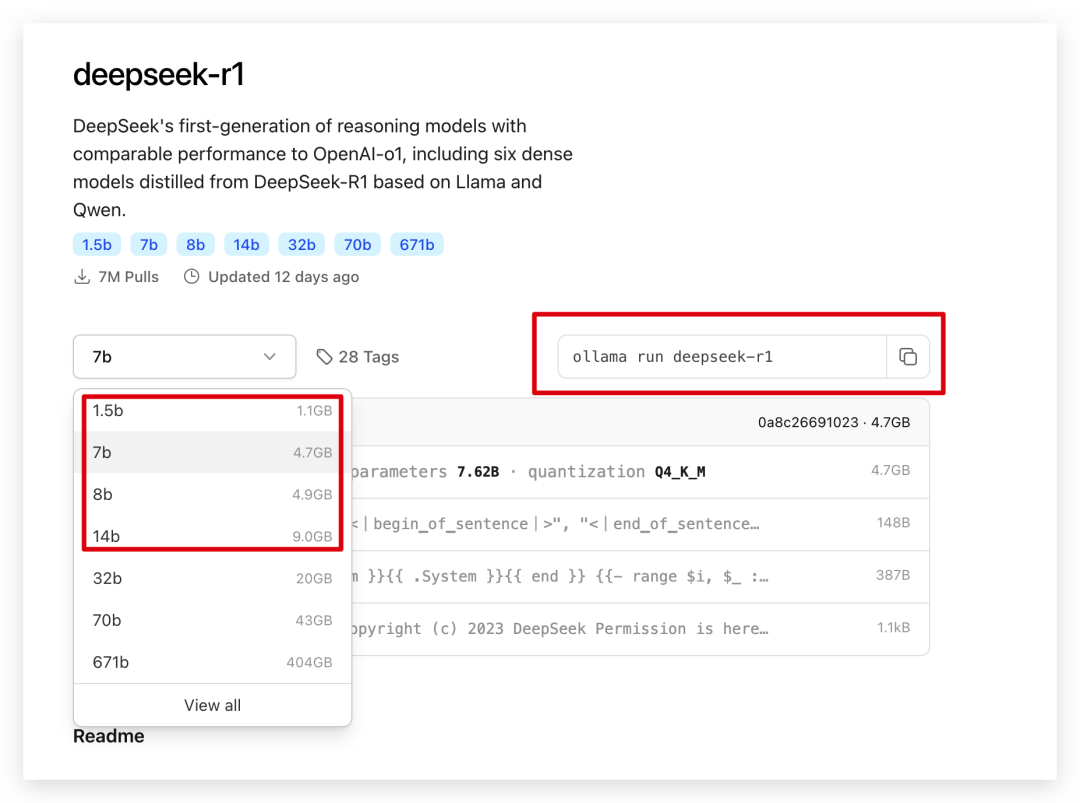

然后打开Ollama的模型列表,搜索到DeepSeek R1

模型对电脑配置要求较高1.5b或7b【右上角的的代码】复制在命令行中运行。本人电脑16G内存选择7b。

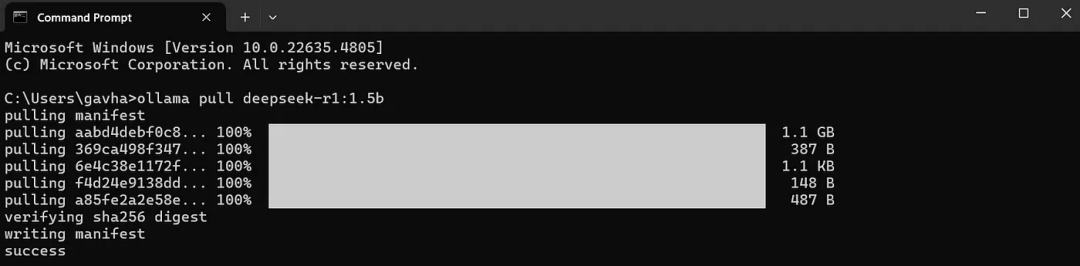

安装需要一段时间,我们等一下就可以等success,就代表安装成功。

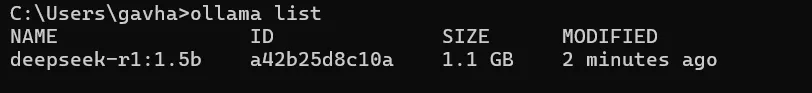

输入【ollama list】,就可以查看安装的模型。

设置安装之后,我们只能在命令行中使用会特别的不方便。

我们需要找到一个第三方客户端。

客户端推荐Chatbox和Cherry Studio,都很优秀。

二、Cherry Studio安装

Cherry Studio是一个特别强大的AI 客户端,支持国内外很多模型。

还内置很多提示词,文生图,文档等功能。

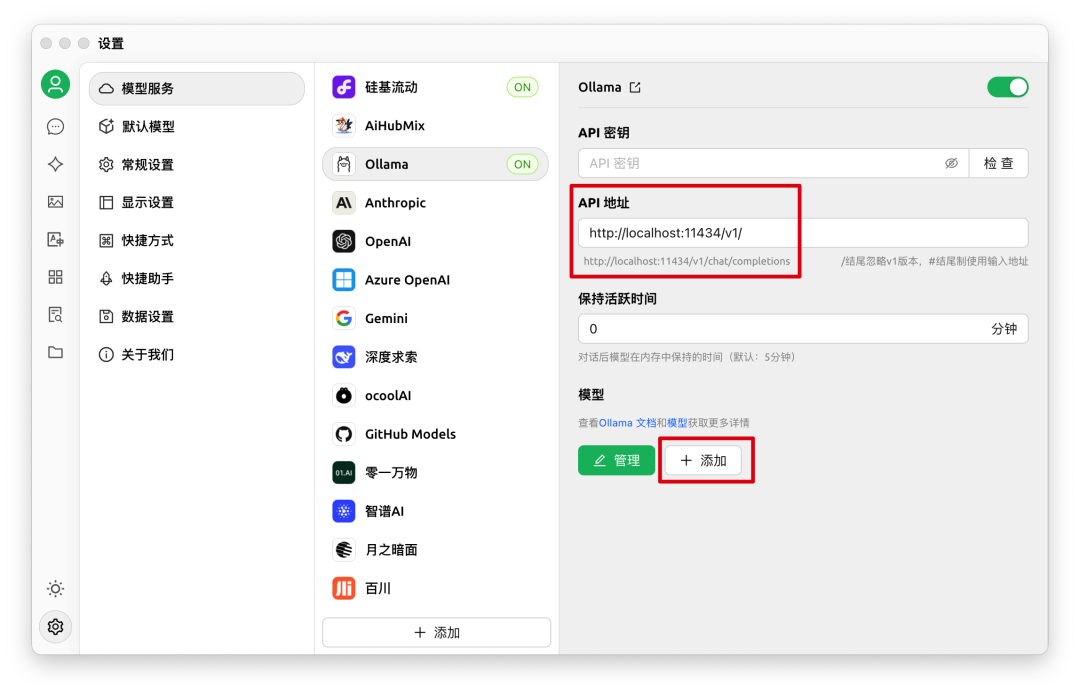

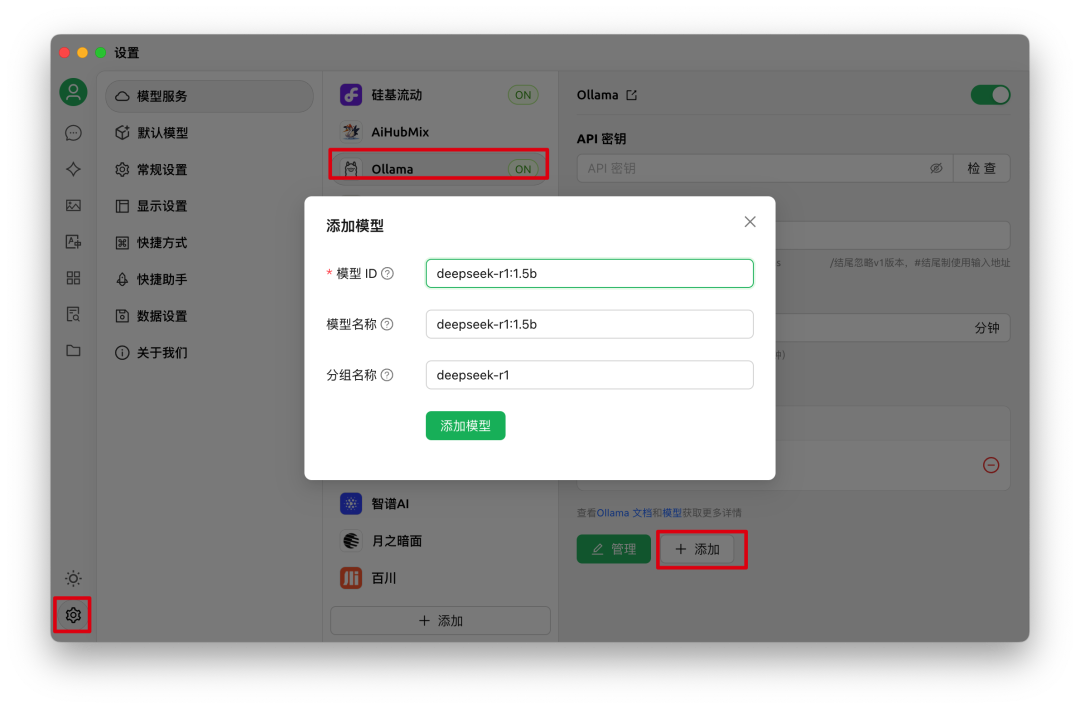

按照下面步骤添加即可。

我们在Cherry Studio 客户端配置Ollama 安装过的模型。

默认API:http://localhost:11434/v1

模型名:deepseek-r1:1.5b

三、硅基流动注册

![]()

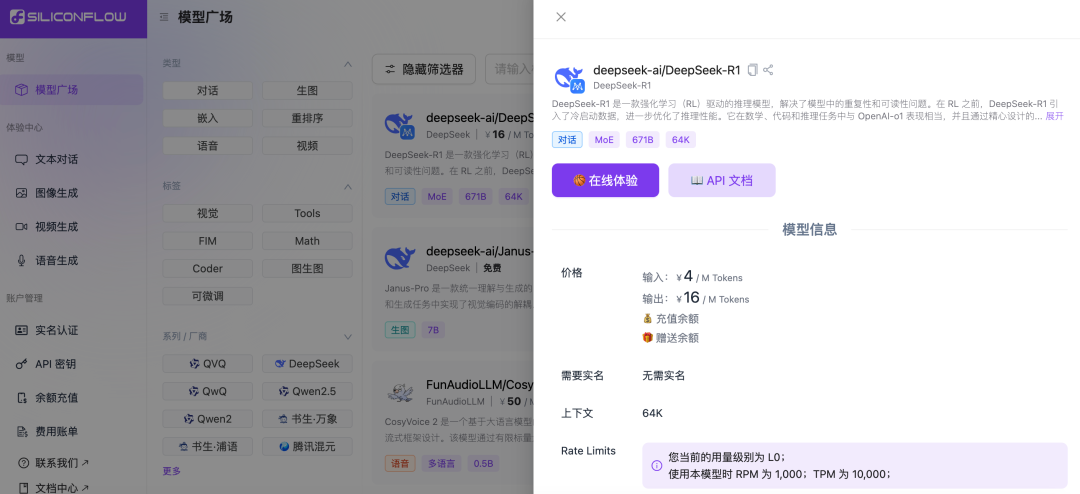

注册登录后,直接在左侧菜单栏找到模型广场,其中列出的模型都是硅基流动支持的,有些是免费的,有些需要消耗平台余额。比如满血版DeepSeek-R1就会消耗余额,而DeepSeek的文生图模型Janus-Pro-7B则是完全免费的。

以满血版DeepSeek-R1为例,点击模型卡片,可以查看模型的详情。可以看到,DeepSeek-R1是一个MoE混合专家模型,满血版参数为671B,上下文长度为64K tokens。

1. 模型配置

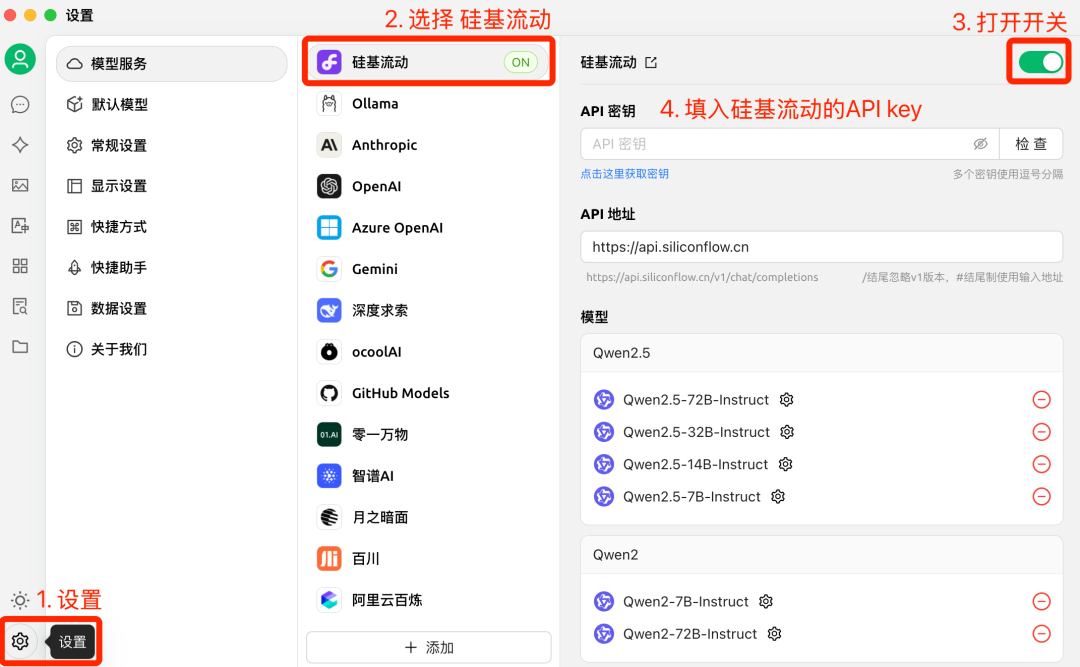

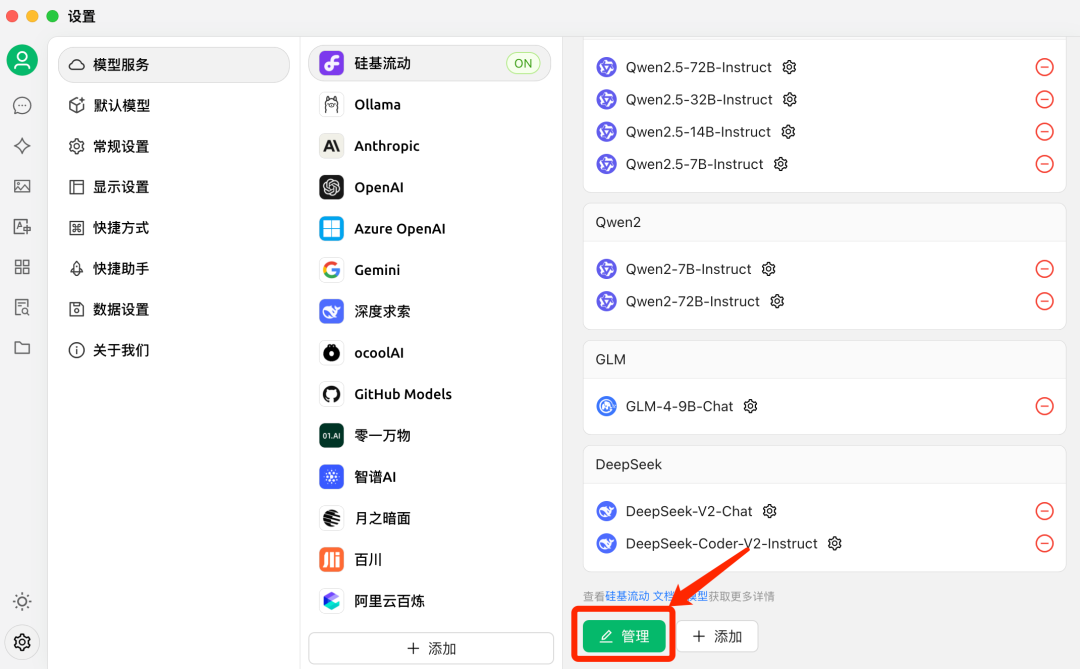

安装好Cherry Studio后,首先需要配置模型。搭建个人知识库,仅硅基流动的模型就足够了,所以只需:点击左下角的设置->选择硅基流动->打开开关->填入硅基流动的API key。

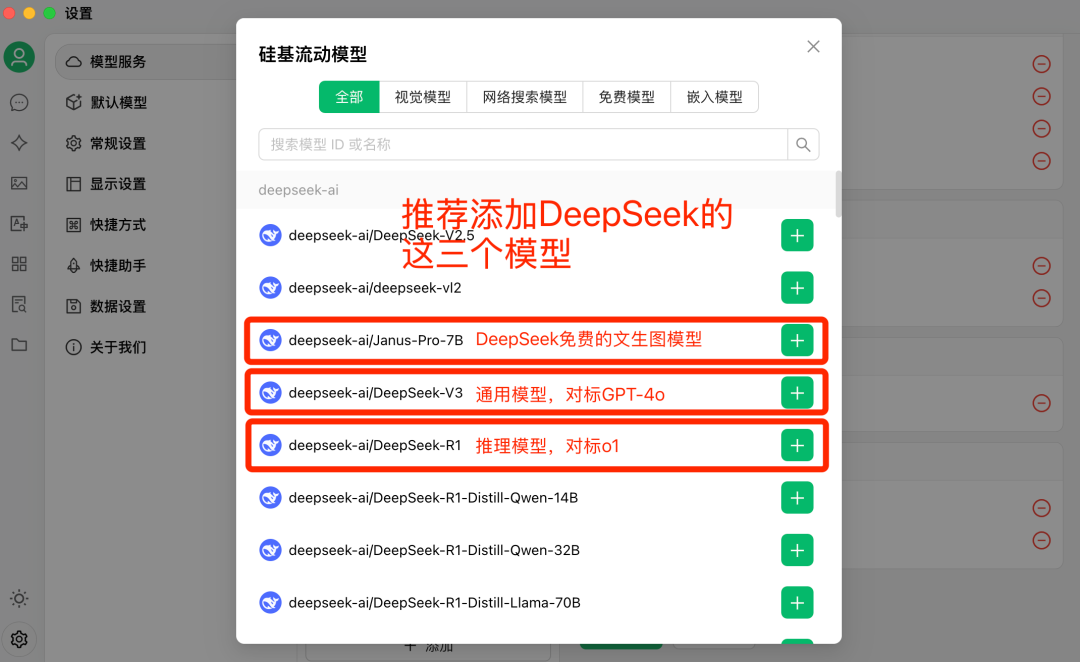

接下来,把需要用到的模型添加上。下拉到最下面,点击绿色的管理按钮。

常规模型中,推荐添加下面三个模型:推理模型DeepSeek-R1、通用模型DeepSeek-V3,以及视觉模型Janus-Pro-7B。

嵌入(embedding)模型,推荐添加下面两个:完全免费的BAAI/bge-m3和付费的Pro/BAAI/bge-m3。

一般说来,免费的BAAI/bge-m3模型就够用。

2. 创建知识库

配置完模型,就可以开始创建知识库了!

点击左侧菜单栏的知识库图标->点击左上角的添加按钮->在弹窗里输入你的知识库名称,随便输,方便查找就行->选择嵌入模型。

嵌入模型选择上一步中添加的免费模型BAAI/bge-m3就可以。

接下来就可以往你创建好的知识库里添加资料,Cherry Studio支持各种类型的资料,比如文件、网址、笔记等等。

以最常见的文件资料为例,直接把PDF拖拽进去,当看到文件右边的状态符号变为绿色的对勾,就说明该文件已经向量化完毕。

3. 和知识库对话

添加完资料,就可以开始检索你的个人知识库了。

两种方式使用。

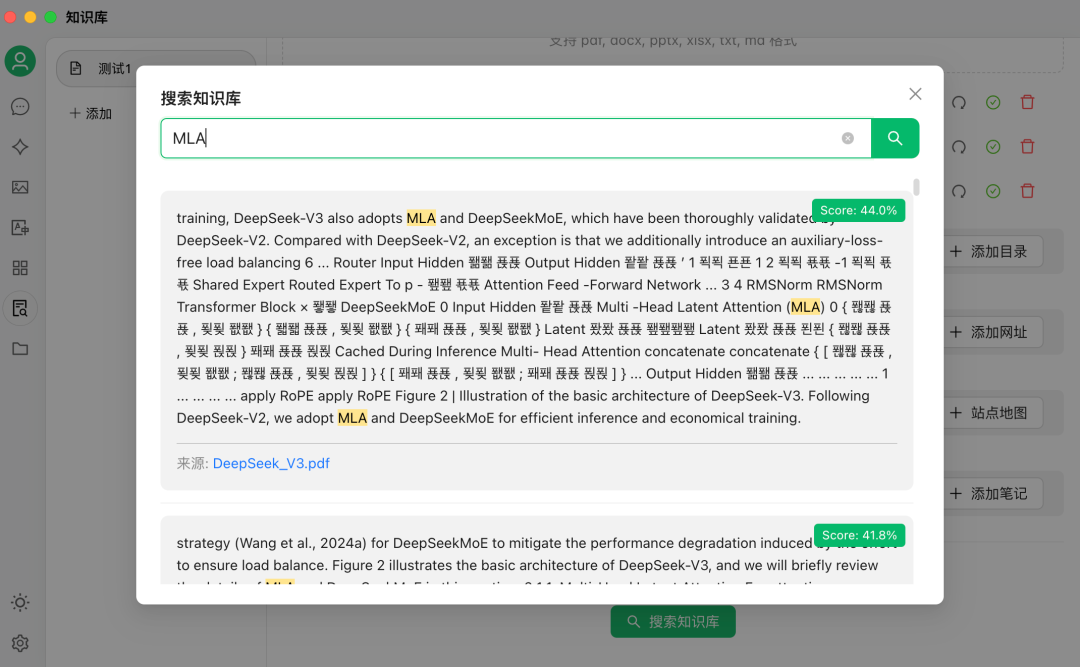

一种是直接在知识库最下面的

搜索知识库,点击后进行搜索。

输入你想搜索的内容,点击搜索按钮。就像下面这样。

第二种方法则更为实用:直接在问答的过程中选中知识库,相当于给LLM添加了额外的上下文信息。

在Cherry Studio的输入框下方,有一个知识库的图标,点击,选择你创建好的知识库。

选中后,知识库的图标会变成蓝色。

这里我默认的模型是DeepSeek-R1。回答前,会先对知识库进行检索,然后把搜索结果投喂给DeepSeek-R1,由模型进行整理、分析,再生成最终的答案。

可以看到,DeepSeek-R1的回答结果是基于知识库内容产生的。

DeepSeek-R1的思考过程。